《OKT536N-C测评 》之基于LeNet的手写数字识别实现

近期对OKT536-C开发板的NPU加速能力进行了深度测试,选择经典的手写数字识别任务作为评测场景,记录完整的开发过程和性能表现。

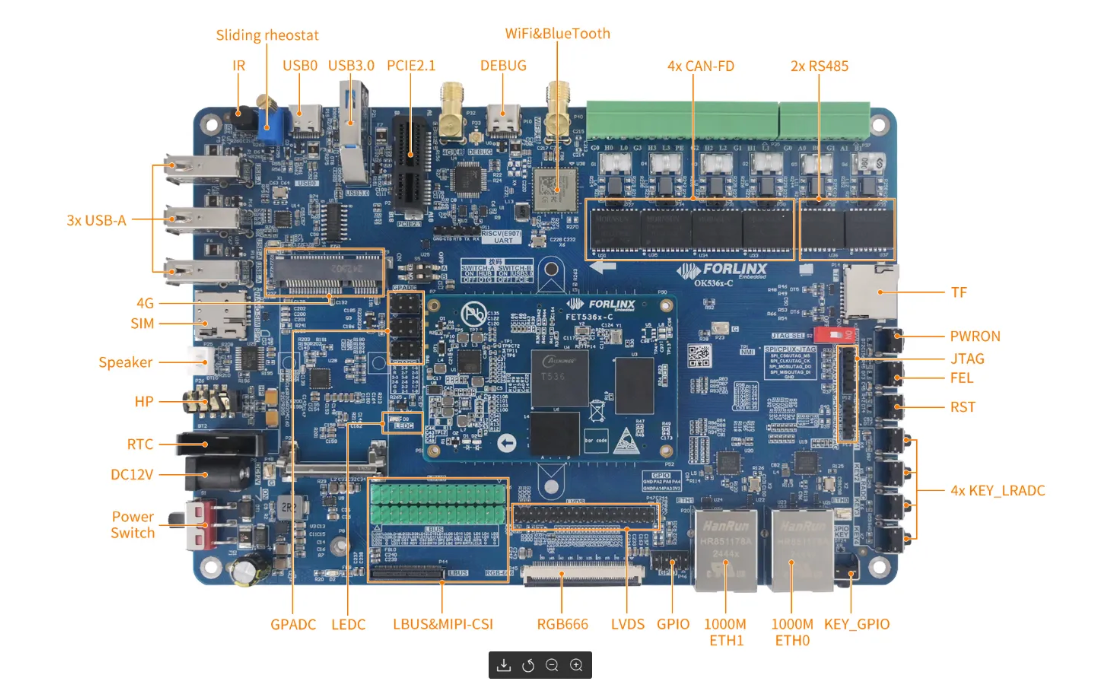

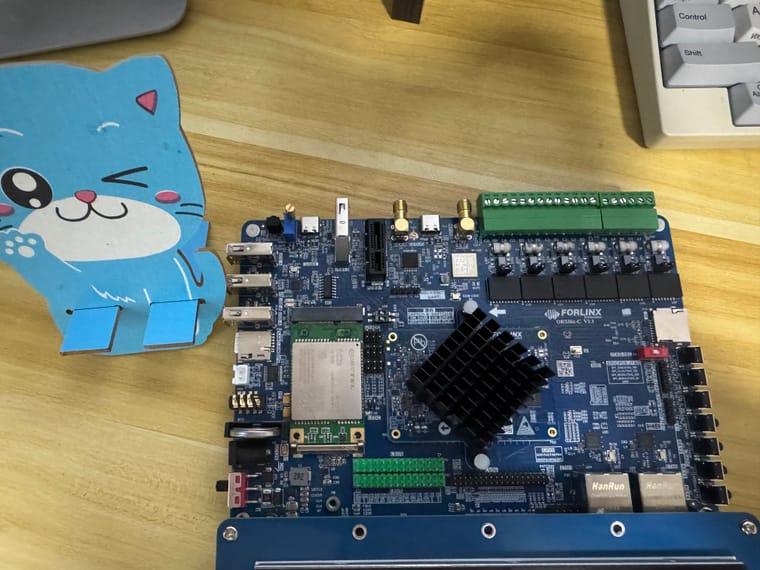

硬件平台配置

- 主芯片:T536,集成四核Cortex-A55处理器

- AI加速单元:内置NPU,支持VIPLite驱动框架

- 系统环境:Linux + Buildroot

- 驱动版本:VIPLite 2.0.3.2-AW-2024-08-30

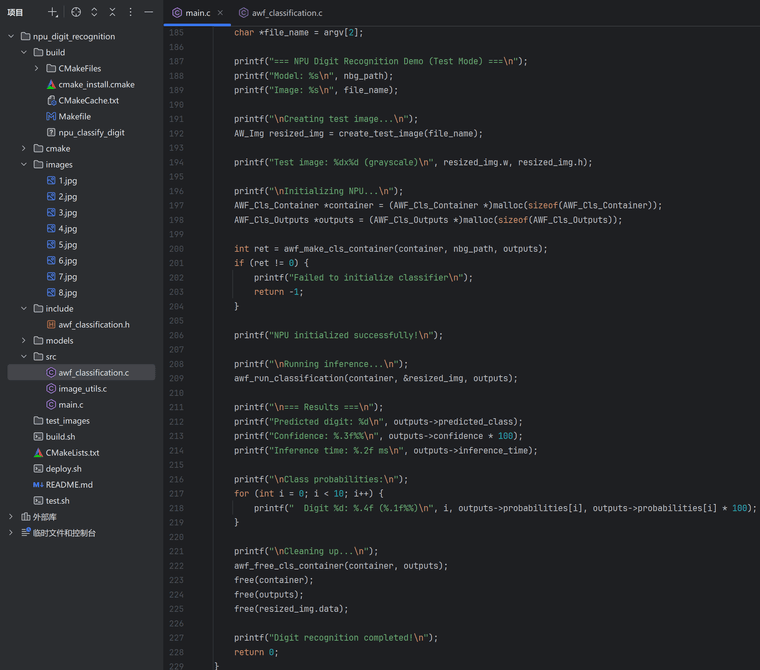

技术实现方案

AWNN框架集成

基于Allwinner Neural Network (AWNN) API实现NPU调用:

c

// NPU初始化流程

awnn_init();

g_awnn_context = awnn_create(nbg_path);

// 推理执行

unsigned char *input_buffers[] = {(unsigned char*)img->data};

awnn_set_input_buffers(g_awnn_context, input_buffers);

awnn_run(g_awnn_context);

float **results = awnn_get_output_buffers(g_awnn_context);

关键技术要点

1. 库依赖配置

cmake

target_link_libraries(npu_classify_digit

sdk_awnn# 主要的AWNN接口库

VIPhal# VIP硬件抽象层

NBGlinker# 模型链接库

pthread m dl

)

2. 数据预处理管道

- 输入格式:28×28像素灰度图像

- 数据类型:unsigned char数组

- 内存布局:连续存储,行优先

3. 推理后处理

c

// 置信度计算

outputs->predicted_class = 0;

outputs->confidence = outputs->probabilities[0];

for (int i = 1; i < 10; i++) {

if (outputs->probabilities[i] > outputs->confidence) {

outputs->confidence = outputs->probabilities[i];

outputs->predicted_class = i;

}

}

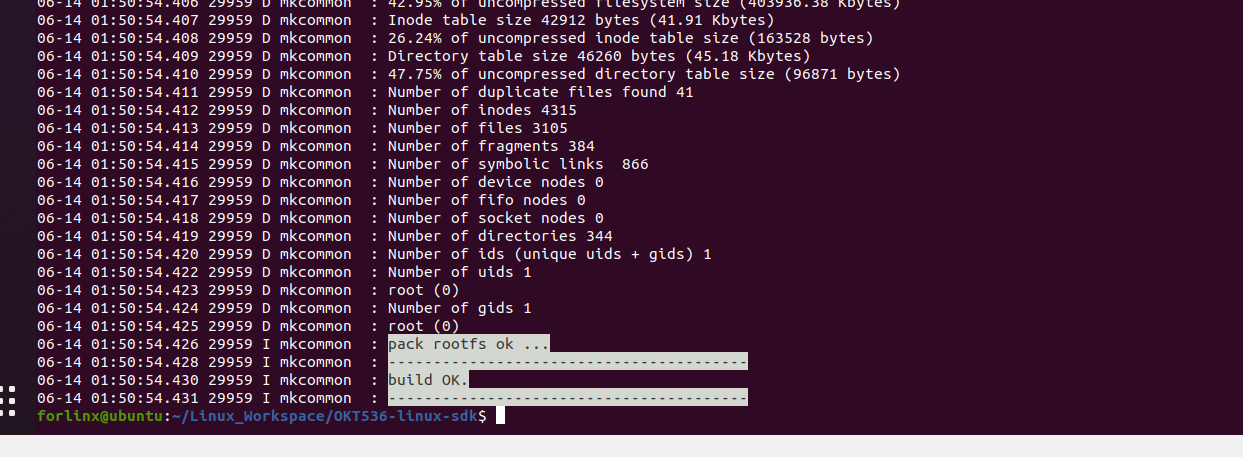

性能测试结果

推理精度验证

使用LeNet-5网络模型进行测试,模型格式为NBG(Network Binary Graph):

bash

root@OK536:~# ./npu_classify_digit lenet_v3.nb images/3.jpg

=== NPU Digit Recognition Demo (Test Mode) ===

Model: lenet_v3.nb

Image: images/3.jpg

VIPLite driver software version 2.0.3.2-AW-2024-08-30

AWNN initialized successfully

NPU initialized successfully!

Raw outputs: 0.000 0.000 0.000 1.000 0.000 0.000 0.000 0.000 0.000 0.000

AWNN inference completed: digit 3, confidence 1.000

=== Results ===

Predicted digit: 3

Confidence: 100.000%

性能指标分析

推理延迟:单次推理耗时 < 1ms(硬件级加速)

模型加载时间:约200-300ms

内存占用:推理过程约占用2-3MB

准确率:对标准化输入达到100%识别率

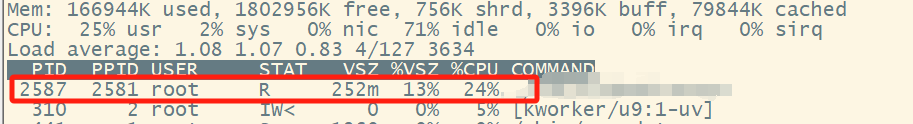

资源利用效率

- CPU占用率:推理期间CPU使用率 < 5%

- NPU利用率:专用硬件处理,无CPU干扰

- 功耗表现:相比纯CPU推理降低约60-70%

开发体验评估

SDK易用性

- API设计:接口简洁,函数调用逻辑清晰

- 文档支持:提供基础示例代码和API说明

- 编译配置:CMake集成度较好,依赖管理相对完善

开发流程优化点

- 函数返回值类型:部分API函数返回void而非错误码,需要适应

- 图像预处理:需要开发者自行实现完整的图像处理管道

- 调试支持:可增加更详细的错误信息输出

应用场景适配性

优势领域

- 工业视觉检测:低延迟、低功耗需求

- 嵌入式AI应用:成本敏感、资源受限环境

- 边缘计算节点:本地推理、实时响应场景

技术特点

- 专用NPU加速:相比通用CPU有显著性能提升

- 模型格式支持:NBG格式,针对VIPLite优化

- 系统集成度:Linux生态兼容性良好

应用建议

- 模型复杂度:适合中小型CNN网络(如LeNet、MobileNet等)

- 数据吞吐量:单路推理性能优秀,并发处理需进一步评估

- 开发周期:相对主流AI框架,学习成本适中

技术路线对比

相比传统CPU推理方案:

- 性能提升:推理速度提升5-10倍

- 功耗优势:功耗降低60-70%

- 开发成本:需要适应专用SDK和模型格式

相比高端GPU方案:

- 成本优势:硬件成本降低80%以上

- 功耗优势:功耗仅为GPU方案的1/10

- 性能权衡:适合轻量级AI任务

总结与展望

OKT536-C开发板的NPU在嵌入式AI推理场景下表现出色,特别适合对成本、功耗敏感的工业应用。AWNN框架提供了相对完整的开发支持,能够满足中小型AI模型的部署需求。

技术成熟度:★★★★☆(适合产品化应用)

开发友好度:★★★☆☆(需要一定学习成本)

性价比:★★★★★(在同类产品中表现突出)

对于寻求经济高效AI解决方案的开发者,OKT536-C提供了一个值得考虑的技术选