NPU 量化模型速度问题

-

大佬们,pegasus上测试picodet模型算力MACC为860M,yolov3为33G,

但部署在V853上测试yolov3 200多ms,picodet却为400多ms,这是为什么呀。 -

@tianjiangfuzi 看一下picodet的模型转换使用的是不是nn模块还是pp模块

-

@yuzukitsuru 额 大佬 请问啥事nn模块和pp模块 nn模块是指torch.nn 吗 还是什么呀 网上没查到什么信息

picodet是用paddlepaddle训练的,模型转换用的是paddle2onnx,然后用onnxsim简化 -

-

@yuzukitsuru 请问这个nb_info 具体怎么用呀 我查看文档资料没看到呀 demo中好像也没有例子

-

@tianjiangfuzi 我晚上有空写一个

-

@yuzukitsuru 好的 感谢

-

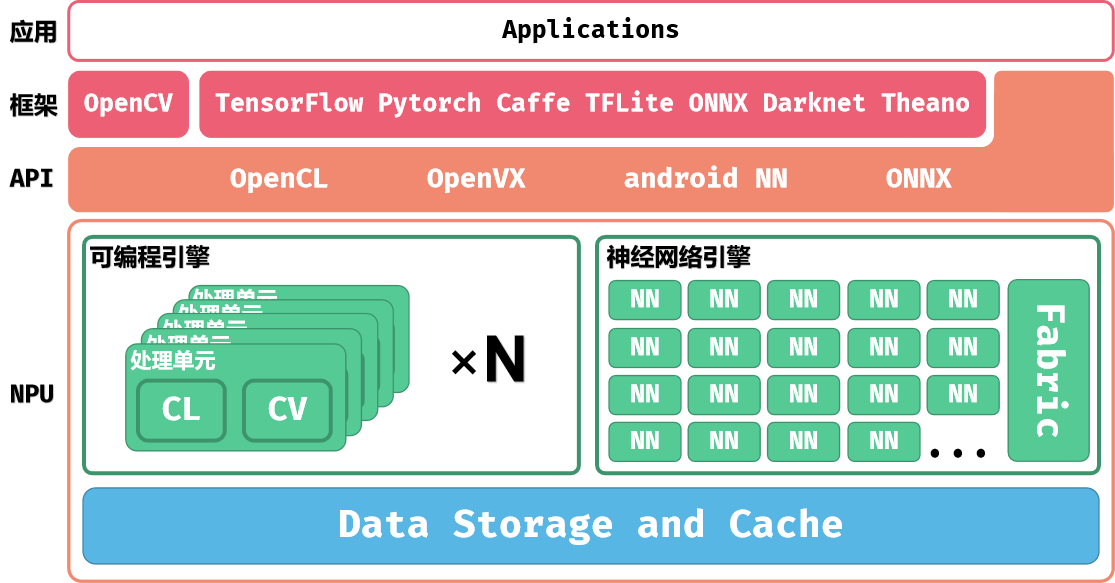

大佬 我看到一些lenet demo中有提到nne 和ppu计算单元,我用的模型中有sigmoid层,输出的tensor有一半是float类型,是不是表示这个模型在pp模块运行呀,这个模块是不是相较于nn模块速度会慢? 是不是只有改模型结构才能提速?还有就是nbinfo是一个解析nb文件的一个可执行文件吗 ?

上边是速度问题!同时我也遇到了精度问题,按照demo量化。无论是int8还是uint8都得到错误的结果,即便精度下降也不应该下降这么离谱,不知道各位有没有遇到过这种情况 -

@tianjiangfuzi 是的,nn只支持uint8, int8,float会被转换到pp计算。nbinfo是一个软件读取解析nb文件的,可以看到他在哪一个核心上运行

Copyright © 2024 深圳全志在线有限公司 粤ICP备2021084185号 粤公网安备44030502007680号